L’intelligence artificielle a franchi un cap. Après les modèles de langage capables de générer du texte ou de code, on voit émerger des agents IA, des systèmes autonomes capables d’observer un environnement, d’analyser des données et d’accomplir des tâches sans intervention humaine directe. Ces agents ne se limitent plus à produire une réponse : ils planifient, prennent des décisions, interagissent avec des API, et s’adaptent pour atteindre un objectif donné.

Au Lab IA d’Eleven Labs, on travaille chaque jour sur la conception d’architectures agentiques capables de structurer ces agents et de les faire collaborer efficacement. Une architecture agent IA, c’est avant tout un cadre technique et logique qui relie plusieurs modèles, outils et processus au sein d’un même système. Elle permet de créer des applications plus spécifiques, capables de s’intégrer à des flux métiers complexes et de délivrer des résultats fiables en temps réel.

Dans cet article, je vais vous expliquer comment fonctionne un agent IA, de quoi se compose son architecture, quelles sont les approches les plus efficaces pour concevoir un système multi-agents, et comment ces technologies transforment déjà les solutions déployées en entreprise.

Qu’est-ce qu’un agent IA ?

Un agent IA est un composant logiciel orienté objectif. Il observe un contexte, prend une décision, puis exécute une action via des outils réels (API, bases, services internes). Contrairement à un LLM généraliste, son périmètre est défini : droits d’accès, responsabilités, conditions d’exécution.

Il repose sur trois briques:

- un moteur de raisonnement (LLM) pour analyser et planifier,

- des outils pour agir,

- une mémoire contrôlée pour conserver le contexte utile.

Il n’apprend pas “tout seul”. Les améliorations passent par des boucles encadrées (ajustements, tests, supervision). Sans cette gouvernance, on obtient de l’automatisation instable.

Dans une architecture agentique, plusieurs agents spécialisés coopèrent, et un orchestrateur coordonne l’ensemble. L’enjeu n’est pas la conversation, mais l’exécution fiable de tâches métier.

Un agent efficace n’est pas polyvalent. Il est précis, délimité et traçable.

Anatomie et fonctionnement d’un agent IA dans une architecture agentique

Un agent IA conversationnel, ou non, fonctionne selon un principe simple, mais redoutablement efficace : percevoir, raisonner, agir. Il reçoit une entrée — une requête utilisateur, une donnée métier, un signal d’un autre agent — qu’il analyse à l’aide de son modèle d’intelligence artificielle, avant de produire une action concrète. Ce cycle perception-action est la base de tout système agentique moderne.

Pour rendre ce fonctionnement plus lisible, je préfère le découper en six briques principales, chacune jouant un rôle précis dans la structure logicielle de l’agent.

Le moteur de raisonnement (le “cerveau”)

C’est le modèle IA — souvent un LLM ou un modèle hybride — qui assure la compréhension et la logique interne de l’agent. Il interprète les instructions, structure les données, et fournit la matière première du raisonnement. C’est la couche qui “pense”, mais elle ne définit pas à elle seule la manière d’atteindre l’objectif.

Les outils et extensions

Un agent n’agit pas dans le vide. Ses outils (API, fonctions, connecteurs internes, bases de données) sont les passerelles vers le monde réel. Ce sont eux qui lui permettent de récupérer des informations, d’automatiser des processus, ou d’exécuter des tâches spécifiques dans une application ou un système d’entreprise. Avec l’arrivée du Model Context Protocol (MCP), cette couche devient encore plus standardisée : les agents pourront interagir avec leurs outils via un protocole unique, sécurisé et interopérable. À terme, la majorité des extensions et connecteurs passeront par le MCP pour garantir une intégration propre et scalable.

La mémoire et la base de connaissances

L’agent conserve à la fois le contexte immédiat (mémoire court terme) et les expériences accumulées (mémoire long terme). Cette mémoire structurée lui permet d’ajuster son comportement, de raisonner de manière plus cohérente et d’éviter les erreurs de répétition.

Le module d’action

C’est la couche d’exécution. Elle transforme le raisonnement en résultat concret : envoyer un message, rédiger un rapport, créer une entrée dans un CRM, ou piloter une autre IA. Dans un système multi-agents, ce module permet aussi la coordination entre agents pour garantir un flux cohérent et sans friction.

L’orchestrateur ou agent superviseur

Dans une architecture multi-agents, l’orchestrateur joue le rôle de “chef d’orchestre”. Il répartit les tâches entre les agents spécialisés (collecte, analyse, génération, validation), agrège leurs résultats et assure la supervision du système.

L’interface de communication

Enfin, l’agent interagit avec le monde extérieur : utilisateurs humains, autres agents ou systèmes logiciels. Cette interface peut être une API, une interface utilisateur, ou une connexion directe à une plateforme métier. C’est elle qui rend l’agent IA opérationnel et exploitable dans un contexte concret.

En combinant ces composants, on obtient des architectures agentiques capables d’orchestrer des flux de travail complexes, d’intégrer des données hétérogènes et d’améliorer leurs performances en continu grâce à l’apprentissage automatique. Cette organisation modulaire et fluide est ce qui permet aux agents IA de fonctionner de manière robuste, évolutive et réellement utile à l’échelle de l’entreprise.

Les modèles d’architecture agentique et leurs applications concrètes

On choisit une architecture agentique en fonction du degré de décision et de contrôle requis. Les agents réactifs sont adaptés aux tâches simples et déterministes : un événement déclenche une action. Pas de mémoire, pas de raisonnement. C’est ce que j’emploie pour la surveillance, l’alerte, la normalisation de flux. Leur avantage est la fiabilité.

Dès qu’il faut analyser, arbitrer ou planifier, on bascule sur des agents délibératifs. Ils construisent une représentation interne du contexte avant de décider. C’est pertinent pour des enjeux complexes, mais la qualité du résultat dépend directement de la qualité du modèle et de la fraîcheur des données. Sans supervision, le risque de décisions incohérentes est réel.

Les architectures hybrides combinent les deux approches : réactivité pour les actions à faible impact, délibération pour les décisions structurantes. Ce modèle fonctionne bien en entreprise, à condition de définir clairement où s’arrête la logique réactive et où commence la planification. Sans cette frontière, l’agent est instable.

Cependant, dès qu’il s’agit d’automatiser un processus métier complet, on dépasse ces modèles. À ce niveau, un seul agent, même sophistiqué, ne suffit pas. Il faut un système multi-agents. Chaque agent est spécialisé et un orchestrateur assure la coordination, la priorisation, la gestion des erreurs et la gouvernance des accès. C’est ce modèle qui permet de passer à l’échelle.

C’est un point important : aujourd’hui, dans un contexte d’entreprise, il n’existe pas de passage à l’échelle sans systèmes multi-agents. Un agent isolé peut démontrer une capacité. Plusieurs agents coordonnés peuvent délivrer une valeur opérationnelle stable, traçable et soutenable. L’enjeu n’est pas d’augmenter “l’intelligence” du modèle, mais de structurer la collaboration, la supervision et l’intégration.

Démarche pour concevoir un système multi-agents IA

Dans un système multi-agents, plusieurs agents spécialisés interagissent, chacun avec un rôle précis, et l’efficacité du système dépend davantage de la coordination que de l’intelligence individuelle des agents.

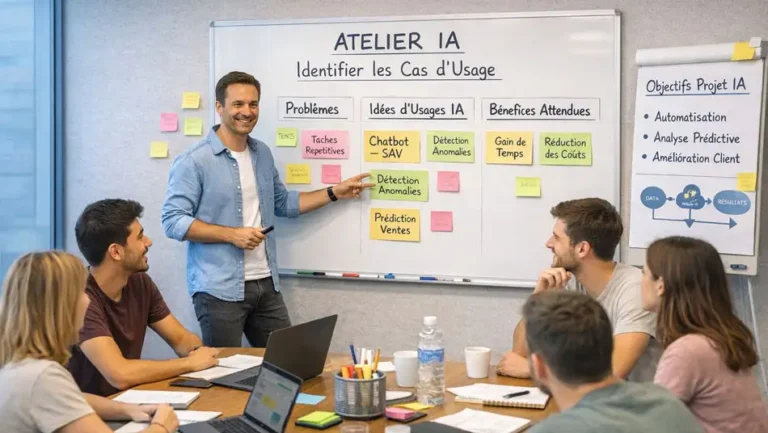

Cadrer le besoin et les objectifs

Chaque projet démarre par une analyse métier précise : quelles tâches répétitives ou chronophages peuvent être confiées à des agents intelligents ? Quelles fonctions doivent rester sous supervision humaine ? L’objectif est de cibler une activité à forte valeur ajoutée, mesurable et maîtrisable. Ce cadrage d’un projet IA fonde la mise en œuvre technique et oriente les choix de modèles.

Sélectionner les modèles et la stack technique

Le choix des grands modèles de langage (LLM), des frameworks et des outils dépend du type d’usage. Certains agents utilisent des modèles open-source optimisés pour le traitement du langage naturel, d’autres reposent sur du deep learning ou de la vision par ordinateur. L’enjeu est d’équilibrer la puissance de calcul, la sécurité, et la facilité d’intégration système.

Implémenter et connecter les agents

La création d’un SMA s’appuie sur des outils et technologies dédiées (MCP, Mastra, LangChain/LangGraph) qui facilitent la mise en place et l’intégration dans l’infrastructure existante. Les développeurs connectent les agents via des API, des connecteurs de données ou des services internes. L’objectif est d’obtenir un flux de travail fluide, fondé sur des éléments interconnectés et des règles de communication bien définies.

Tester, itérer et superviser

L’implémentation doit être progressive : prototype IA, test interne, puis déploiement pilote. On mesure le temps de réponse, la fiabilité des résultats, la conformité aux règles métier et la stabilité des interactions. Les journaux d’exécution et les tableaux de bord d’observabilité sont essentiels pour comprendre comment les agents raisonnent, quelles données ils utilisent et où apparaissent les erreurs. La supervision humaine reste une clé de sécurité : un SMA doit toujours permettre un contrôle et une validation avant toute action à fort impact.

Optimiser et faire évoluer le système

Une fois le système en production, la vraie phase de développement continu commence. On analyse les échecs, on ajuste les prompts, on redistribue les tâches entre agents, on améliore la planification et on teste de nouvelles versions de modèles via de l’A/B testing. L’architecture doit pouvoir évoluer au fil du temps : ajout de nouveaux agents, refonte de l’orchestration, adaptation aux besoins métiers et aux innovations en machine learning.

Un système multi-agents réussi n’optimise pas “l’intelligence” d’un agent. Il optimise la circulation de l’information, la clarté des responsabilités et la fiabilité de l’exécution. C’est cette rigueur qui permet de passer de la preuve de concept à la valeur opérationnelle.

Cas d’usage — Un agent IA WhatsApp pour la collecte de disponibilités

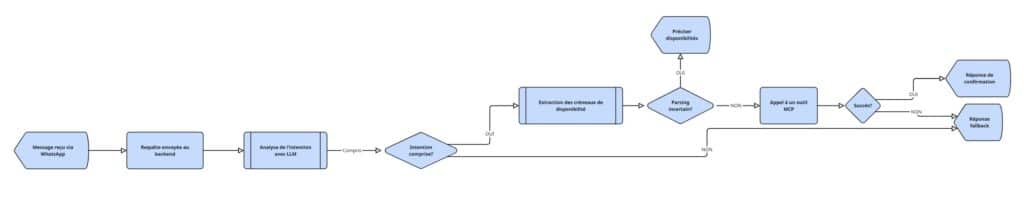

Pour vous donner plus de concret, je vais vous présenter un cas d’usage d’un agent IA WhatsApp. La prise de rendez-vous est un bon exemple d’où l’IA apporte de la valeur rapidement : c’est répétitif, à faible enjeu, mais coûte du temps humain dès qu’il faut clarifier, reformuler ou proposer des alternatives. On va voir ici comment automatiser cette tâche grâce à l’IA pour gagner en fluidité et en productivité :

Comment ça fonctionne, concrètement

1. Message reçu via WhatsApp

L’utilisateur envoie un message du type « Salut, je suis dispo mardi après-midi ou jeudi matin pour échanger. »

Le message arrive via l’API WhatsApp Business, normalisé côté backend (langue, numéro, fuseau horaire, identité).

2. Passage au backend

Le backend nettoie le message, masque les données sensibles et ajoute le contexte utile (profil, historique, type de rendez-vous). C’est aussi lui qui prépare le prompt d’analyse pour le modèle.

3. Analyse d’intention avec un LLM

Le grand modèle de langage détecte ce que veut dire l’utilisateur.

→ Si l’intention “disponibilités” est claire, il extrait les créneaux (jour, heure, durée).

→ Si c’est flou, l’agent rebondit avec un fallback simple : “Tu préfères un créneau de 30 ou 45 minutes ? Plutôt cette semaine ou la suivante ?”

4. Appel à l’outil MCP (calendrier)

Une fois les créneaux extraits, l’orchestrateur appelle l’outil MCP pour vérifier les disponibilités réelles côté agenda. Le modèle n’invente rien : il interroge, reçoit la réponse, et agit uniquement si tout est conforme.

5. Confirmation ou fallback

→ Si tout est OK, l’agent répond : “Parfait, j’ai trouvé un créneau jeudi à 10h30. Tu veux que je le bloque ?”

Après confirmation, il crée l’événement, envoie l’invitation et met à jour le CRM.

→ Si ça coince (conflit ou erreur MCP), il relance avec un fallback : “Ce créneau n’est plus libre. Voici trois autres options possibles : mercredi 11h, jeudi 15h ou vendredi 9h30.”

Ce que l’agent fait bien

Il comprend le langage naturel, sans exiger une syntaxe rigide. Il sait lire “mardi aprem” ou “en fin de journée” et traduire ça en plage horaire exploitable. Il n’agit jamais dans le vide : chaque action passe par l’outil MCP, qui joue le rôle de vérité externe (le calendrier).

Et surtout, il garde le contrôle : tout est tracé, versionné et supervisé. Les requêtes sont journalisées, les erreurs capturées, les PII masquées. Si le modèle ne comprend pas, il revient vers l’utilisateur proprement, sans tourner en boucle ni forcer une réponse.

Gouvernance, supervision et risques dans les architectures d’agents IA

Quand on fait interagir plusieurs agents IA dans une même infrastructure, la technique ne suffit plus. Ce qui fait la différence, c’est la gouvernance. Sans cadre clair, même le meilleur modèle peut se transformer en bombe à retardement. Voilà comment garder le contrôle sans freiner l’innovation.

- Sécurité avant tout : chaque agent doit avoir un périmètre précis. Il utilise uniquement les données et outils dont il a besoin, rien de plus. Les flux sont chiffrés, les accès tracés, et les journaux d’exécution conservent la mémoire de chaque action.

- Supervision humaine obligatoire : même dans un système distribué, quelqu’un doit pouvoir appuyer sur “pause”. Les tableaux de bord, alertes et métriques en temps réel garantissent qu’on garde la main à tout moment.

- Explicabilité intégrée : un agent IA ne doit jamais être une boîte noire. Chaque appel, chaque décision doit être traçable. On doit pouvoir rejouer le raisonnement complet pour comprendre le “pourquoi” derrière le résultat.

- Évolutivité maîtrisée : plus il y a d’agents, plus le système devient instable s’il n’est pas testé, observé et versionné. L’orchestration, les tests automatisés et la supervision continue sont vos meilleures assurances qualité.

- Innovation responsable : l’objectif n’est pas de tout automatiser, mais d’orchestrer intelligemment. Les systèmes multi-agents doivent collaborer comme une équipe — chacun avec son rôle, ses limites et sa valeur ajoutée.

En résumé, une architecture agentique performante, ce n’est pas celle qui fait tout toute seule, mais celle qui agit de manière autonome sans jamais sortir du cadre.

Tendances et perspectives d’évolution des architectures agentiques

On est clairement à un tournant. L’architecture agentique n’est plus un concept de labo, c’est le nouveau standard vers lequel l’intelligence artificielle générative évolue naturellement. Les grands modèles de langage (LLM) deviennent des briques parmi d’autres dans des systèmes multi-agents capables de collaborer, de raisonner et d’agir dans des environnements complexes.

Ce qui se dessine aujourd’hui, c’est une nouvelle couche d’intelligence collective : des agents spécialisés, connectés à des outils métiers, qui communiquent entre eux pour exécuter des workflows complets sans intervention humaine directe. On passe d’un modèle de réponse isolée à un modèle d’action coordonnée.

Plusieurs tendances fortes se démarquent :

- Agents connectés à la data : les pipelines d’IA intègrent de plus en plus des architectures data robustes, permettant à chaque agent d’accéder en temps réel à des sources fiables et contextualisées, comme c’est le cas de l’IA dans l’e-commerce.

- Interopérabilité via le MCP : les serveurs Model Context Protocol ouvrent la voie à des systèmes où les agents de différentes plateformes peuvent coopérer de manière standardisée, à grande échelle.

- Architecture hybride : les solutions mêlant LLM généralistes, modèles spécialisés et moteurs de règles offrent une combinaison puissance + précision, adaptée aux environnements d’entreprise.

- Automatisation des processus métier : les agents deviennent des collaborateurs virtuels intégrés aux outils internes (CRM, ERP, tickets support), capables d’interagir avec les utilisateurs et de déclencher des actions réelles.

- IA souveraine et éthique : la maîtrise des données, la transparence et la conformité deviennent des axes de différenciation aussi importants que la performance technique.

Et j’ajouterais une tendance qui va, selon moi, devenir incontournable très rapidement : l’arrivée de l’UI directement dans les agents, via le MCP UI. OpenAI commence à l’intégrer, et Shopify a déjà ouvert la voie. L’idée est simple mais révolutionnaire : au lieu d’un texte et de quelques images, les agents pourront afficher de vrais composants d’interface interactive en réponse à une requête — formulaires, tableaux dynamiques, visualisations, boutons d’action… et l’utilisateur pourra interagir directement avec ces composants.

Dans les deux prochaines années, on va voir émerger des architectures distribuées plus robustes, inspirées du fonctionnement du cerveau humain : perception, raisonnement, mémoire, action. L’objectif n’est plus de créer un agent unique ultra-puissant, mais des écosystèmes d’agents spécialisés, orchestrés intelligemment, capables de s’adapter en continu.

En clair, on sort de l’ère du prompt pour entrer dans celle de l’automatisation orchestrée. Le futur de l’IA ne sera pas monolithique, il sera agentique, modulaire et collectif.

Conclusion — L’avenir des architectures agentiques et du Model Context Protocol (MCP)

On passe d’une IA centrée sur la génération de réponses à des systèmes capables d’agir. Les architectures agentiques et les systèmes multi-agents deviennent le standard dès qu’il s’agit d’automatiser des processus métier complets, à l’échelle. Le MCP joue un rôle clé dans cette transition en permettant aux agents de se connecter directement aux outils et aux données de l’entreprise, de façon sécurisée et gouvernée.

Au Lab IA d’Eleven Labs, on conçoit et déploie des architectures agentiques adaptées aux environnements réels : intégration aux systèmes internes, supervision, traçabilité, montée en charge. L’objectif n’est pas d’ajouter de l’IA, mais de construire des automations fiables, pilotées et durables. On accompagne aussi les entreprises dans la détection des cas d’usages IA à fort ROI dans leur environnement grâce à un audit IA des processus ciblé.

Vous explorez ces usages dans votre organisation ?

Échangeons sur vos cas concrets et voyons comment bâtir des agents réellement utiles et capables de tenir en production.